Antropomorfismo

El peligro del antropomorfismo deshonesto en los chatbots

La interactividad humanoide puede parecer inteligente, pero causar confianza excesiva.

15 de enero de 2024 Revisado por Michelle Quirk

Los puntos clave

- El diseño antropomórfico puede ser útil, pero poco ético cuando lleva a pensar que es algo que no es.

- Un chatbot puede explotar el “procesamiento heurístico”, invitándonos a asignar responsabilidad moral erronea.

- Las características deshonestas de aspecto humano agravan desinformación y discriminación en chatbots.

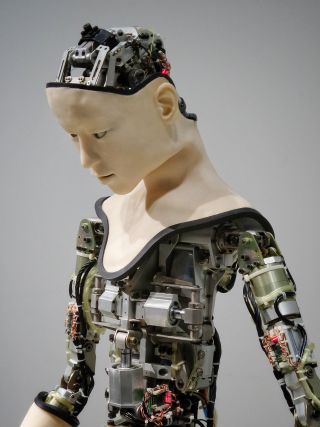

Es una tendencia universal a asignar o imputar cualidades emocionales, cognitivas y de comportamiento humanas a criaturas y cosas no humanas. Los búhos son “sabios”. Los ríos crecidos están “furiosos” y “enojados”. Los conductores personalizan los faros para que parezcan ojos y dan nombres y géneros a sus vehículos. “Encontramos rostros humanos en la luna, ejércitos en las nubes”, escribió el filósofo David Hume en la década de 1750, “y… si no lo corrige la experiencia y la reflexión, atribuimos malicia o buena voluntad a todo lo que nos duele o nos agrada”. Nuestro impulso de antropomorfizar continúa con la tecnología, desde el lenguaje que utilizamos (inteligencia artificial) hasta el diseño deliberado de robots de compañía agradables y tiernos. Este impulso puede tener muchos beneficios. Pero diseñar tecnología para que “actúe” como una persona o tenga características humanas también puede ser manipulador y explotador.

Los chatbots y los grandes modelos lingüísticos (LLM) sobre los que se basan nos muestran los peligros del antropomorfismo deshonesto. Construidos con características humanas que se presentan como si tuvieran capacidades cognitivas y emocionales que en realidad no poseen, su diseño puede engañarnos haciéndonos confiar demasiado en ellos, sobreestimar sus capacidades y tratarlos erróneamente con un grado de autonomía que puede causar una grave confusión moral. Los chatbots programados para expresar sentimientos o que brindan respuestas como si estuvieran escribiendo en tiempo real plantean preguntas importantes sobre el antropomorfismo ético por parte de los desarrolladores de IA generativa.

Motivaciones para la antropomorfización

Tenemos dos motivaciones importantes para asignar cualidades humanas a agentes no humanos, han sugerido los teóricos de la tecnología. Una es nuestra necesidad de “experimentar competencia” e interactuar eficazmente con nuestro entorno. Este tipo de antropomorfización nos ayuda a “comprender” el mundo en nuestros términos humanos. La otra es satisfacer nuestra necesidad de forjar vínculos sociales que, en ausencia de otros humanos, pueden extenderse fácilmente a forjar conexiones similares a las humanas con entidades no humanas, como los robots de compañía para los ancianos. Estas motivaciones están detrás del “antropomorfismo por diseño” (Salles et al., 2020).

Sin embargo, puede ocurrir un antropomorfismo deshonesto cuando una tecnología se “humaniza” con el objetivo de engañar a los humanos para que interactúen con ella como si fuera algo que no es: “aprovecha las debilidades cognitivas y perceptivas intrínsecas y profundamente arraigadas de las personas en su contra”, como señala Brenda. Advierten Leong y Evan Selinger (2018). Las herramientas de IA generativa presentan una serie de características antropomórficas diferentes. Algunos están diseñados explícitamente para parecerse a los humanos, como Character.ai, mientras que otros “parecen” ser humanos como subproducto de su diseño, como Claude o ChatGPT. El punto es que el diseño responsable requiere que los desarrolladores piensen más profundamente sobre por qué se crean tales características.

Ver una máquina como fuente de comunicación

Gracias a décadas de investigación sobre la interacción persona-computadora (IPC), sabemos que poderosas respuestas y suposiciones psicológicas gobiernan en gran medida nuestras interacciones con la tecnología (p. ej., Sundar et al., 2015). Tendemos a percibir las máquinas o las tecnologías digitales como algo más que un simple medio o canal de comunicación, sino más bien una fuente de comunicación. Esta es una distinción importante. Ver una máquina como una fuente nos lleva a interactuar socialmente con ella. Tratamos las tecnologías que tienen características sociales de manera social. Mostramos cortesía. Esperamos reciprocidad. Hacemos suposiciones sobre su inteligencia, su autonomía e incluso su capacidad de creatividad. En otras palabras, respondemos a una computadora tal como responderíamos a otro ser humano como fuente.

Por supuesto, no hacemos esto todo el tiempo. Una tecnología debe tener tres elementos clave para desencadenar esta respuesta social: debe ser interactiva, utilizar lenguaje natural y cumplir roles que antes desempeñaban los humanos. Los chatbots, por supuesto, hacen un trabajo fabuloso al marcar las tres casillas. Podría decirse que representan el pináculo de esta evolución tecnológica. Por diseño, los chatbots nos invitan a tratarlos como una fuente de comunicación. En otras palabras, por diseño, los chatbots están diseñados para explotar nuestro procesamiento heurístico. Las cuestiones éticas que plantean tales características de diseño deben quedar claras. Por eso, cuando los chatbots están diseñados para responder a nuestras indicaciones con expresiones de emoción, podemos objetar que tales características abusan de nuestra tendencia a participar en razonamientos y percepciones antropomórficas. También es la razón por la que Leong y Selinger incluyen tales características como parte de su “Taxonomía del antropomorfismo deshonesto”, a pesar de que su lista es anterior al lanzamiento de ChatGPT por varios años.

Un ejemplo flagrante de lo que se puede llamar antropomorfismo deshonesto es cómo las herramientas de chatbot responden a nuestras indicaciones en “tiempo humano”. En realidad, sus respuestas a nuestras indicaciones se miden en nanosegundos. Son instantáneos. Pero los desarrolladores de varios chatbots, incluidos ChatGPT de OpenAI y Claude de Anthropic, han ralentizado deliberadamente las respuestas para que aparezcan en la pantalla como si las estuvieran escribiendo y presentándonos. Los diseñadores de OpenAI han decidido explícitamente presentar el chatbot como más “humano”.

¿Por qué harían esto? Porque detona para nosotros la heurística de “la máquina como fuente”, y es probable que la tratemos como más “real” de lo que realmente es. Cuando se le hace esta misma pregunta a ChatGPT, responde que es “una función fácil de usar diseñada para hacer que las interacciones con ChatGPT sean más naturales y satisfactorias”. Dice: “Cuando las respuestas parecen como si alguien estuviera escribiendo, se crea la ilusión de interacción en tiempo real, lo que hace que la conversación se sienta más dinámica e interactiva. Esto ayuda a los usuarios a sentir que están teniendo una conversación genuina”. Consideremos eso por un momento. Es una característica diseñada para explotar nuestro procesamiento heurístico y pensar que es algo que no es. Es una característica de diseño para engañarnos de manera más efectiva.

Otra preocupación ética aquí es la discriminación que puede ocurrir cuando la configuración algorítmica de los LLM se puede ajustar para “actuar como” una persona específica en función de su raza, etnia u otros “rasgos”; en otras palabras, cuando el LLM está literalmente antropomorfizado. Un estudio reciente demostró cómo al hacerlo, el chatbot discriminaba varios grupos demográficos y entregaba contenido significativamente más “tóxico” cuando estaba “configurado” para actuar como un determinado grupo, como asiático, no binario o femenino (Deshpande et al., 2023).

Ya sea por ignorancia o por falta de atención, los desarrolladores y ejecutivos que antropomorfizan los chatbots de maneras que resultan en engaño o depredación, o que llevan a los usuarios a tratarlos como algo que no son, no nos hacen ningún favor a todos.

A version of this article originally appeared in Inglés.